Robots.txt – Comment l’optimiser pour son site web ?

Podcast: Play in new window | Download (Duration: 12:39 — 10.6MB)

S'inscrire au podcast via une plateforme : Apple Podcasts | Spotify | Android | Deezer

Avez-vous déjà entendu parler du fichier “robots.txt” sans vraiment savoir ce que c’est son importance pour votre site web ? Vous n’êtes pas seul(e) ! Pourtant, bien maîtrisé, ce petit fichier peut faire toute la différence dans la manière dont les moteurs de recherche, tels que Google, perçoivent et interagissent avec votre site. Dans cet article, nous plongerons dans le monde fascinant du “robots.txt”, découvrant son rôle, comment le configurer et, surtout, comment l’optimiser pour le succès de votre site internet. Que vous soyez un entrepreneur, un blogueur, ou simplement curieux du monde digital, ce guide est fait pour vous.

Table des matières

Toggle1. Qu'est-ce que le fichier Robots.txt ?

1.1 Définition et rôle du fichier robots.txt

Le fichier robots.txt est un petit document que vous trouverez à la racine de la plupart des sites web. Imaginez-le comme un gardien qui donne des directives aux moteurs de recherche sur les pages qu’ils peuvent ou ne peuvent pas explorer et indexer. En termes simples, c’est un moyen pour les propriétaires de site de dire : “Hey, Google (ou n’importe quel autre moteur de recherche), vous pouvez regarder ces pages, mais pas celles-ci.”

1.2 Pourquoi est-il crucial pour votre site web ?

Maintenant, vous pourriez vous demander, “Pourquoi voudrais-je empêcher les moteurs de recherche de voir certaines parties de mon site ?” La réponse est simple : certains contenus ne sont pas pertinents pour les visiteurs ou pourraient même être préjudiciables à votre SEO. Par exemple, si vous avez une section de votre site réservée à la gestion interne ou aux tests, vous ne voudriez probablement pas que cette section apparaisse dans les résultats de recherche. Le fichier robots.txt vous permet de contrôler cela.

2. Comment fonctionne le Robots.txt pour le SEO ?

2.1 Comprendre les robots des moteurs de recherche (User-agents)

Les moteurs de recherche, comme Google ou Bing, utilisent des “robots” (aussi appelés “crawlers” ou “spiders“) pour parcourir le web. Ces robots scannent constamment le contenu des sites web pour le comprendre et le classer. Lorsqu’un robot visite votre site, il vérifie d’abord votre fichier robots.txt pour savoir quelles pages il est autorisé à scanner.

2.2 Règles de base : Allow, Disallow, et Crawl-delay

Dans votre fichier robots.txt, vous verrez principalement trois directives :

- Allow : Indique aux robots qu’ils peuvent accéder à une certaine page ou section.

- Disallow : C’est le contraire d’Allow. Il dit aux robots de ne pas accéder à une certaine page ou section.

- Crawl-delay : Cela demande aux robots d’attendre un certain nombre de secondes entre les scans de pages. C’est utile si vous ne voulez pas que les robots surchargent votre serveur en visitant trop de pages trop rapidement.

2.3 Comment le fichier robots.txt influence l'indexation

Il est crucial de comprendre que le fichier robots.txt n’empêche pas totalement une page d’être indexée. Cela signifie que même si vous utilisez “Disallow” pour une page, elle pourrait encore apparaître dans les résultats de recherche si d’autres sites la lient. Cependant, en utilisant le fichier robots.txt, vous donnez des directives claires sur où vous souhaitez que les robots des moteurs de recherche se concentrent, ce qui peut aider à optimiser votre présence en ligne.

3. Étapes pour créer un fichier Robots.txt pour son site

3.1 Choisir l'emplacement approprié (racine du domaine)

Imaginez votre site web comme une maison. La racine du domaine est comme l’entrée principale. Votre fichier robots.txt doit être placé ici afin que les robots des moteurs de recherche puissent le trouver facilement dès qu’ils “frappent à la porte” de votre site. En termes techniques, cela signifie que votre fichier devrait être accessible via une URL du type : “https://www.votresite.fr/robots.txt”

3.2 Utilisation des outils adéquats : générateurs de robots.txt

Vous n’avez pas besoin d’être un expert en codage pour créer un fichier robots.txt. De nombreux outils en ligne gratuits vous permettent de générer ce fichier en quelques clics. Vous n’avez qu’à préciser quelles parties de votre site vous souhaitez cacher, et l’outil vous fournira le texte à copier dans votre fichier.

3.3 Exemples de codes à intégrer selon vos besoins

Autoriser tous les robots à tout explorer :

Empêcher tous les robots d’accéder à une section spécifique (par exemple, la section “admin”) :

4. Comment optimiser son Robots.txt pour un meilleur SEO ?

4.1 Éviter de bloquer les ressources essentielles

Lorsque vous dites aux robots de ne pas explorer certaines parties de votre site, assurez-vous de ne pas leur interdire des pages ou des ressources essentielles, comme les images ou les fichiers CSS qui rendent votre site esthétiquement agréable. Si vous bloquez ces ressources, votre site pourrait ne pas s’afficher correctement dans les aperçus de recherche.

4.2 Utilisation de la directive "Sitemap" pour indiquer l'emplacement du sitemap XML

Un sitemap est comme une carte de votre site, aidant les moteurs de recherche à comprendre sa structure. Dans votre fichier robots.txt, ajoutez une ligne indiquant où cette carte peut être trouvée. Par exemple :

4.3 Comment éviter les erreurs courantes dans le fichier robots.txt

Il est courant de faire de petites erreurs en rédigeant le fichier robots.txt, comme oublier de préciser un “User-agent” ou utiliser des chemins incorrects. Pour éviter ces pièges, utilisez toujours des outils de validation et de test (comme celui de la Google Search Console) avant de finaliser votre fichier.

4.4 Optimisation pour les sites multilingues ou multi-pays

Si votre site est disponible en plusieurs langues ou vise plusieurs pays, vous voudrez peut-être donner des directives différentes selon les régions ou les langues. Par exemple, vous pourriez vouloir que les robots explorent la version française de votre site, mais pas la version allemande. Votre fichier robots.txt peut être adapté pour refléter ces préférences.

5. Tester et valider son fichier Robots.txt

5.1 Utilisation de l'outil de test de robots.txt de Google Search Console

Une fois que vous avez créé ou modifié votre fichier robots.txt, il est important de s’assurer qu’il fonctionne comme prévu. Heureusement, Google propose un outil pratique pour cela dans la Google Search Console.

- Comment l’utiliser :

- Connectez-vous à la Google Search Console et sélectionnez votre site.

- Dans le menu de gauche, allez dans “Exploration” puis “Tester le fichier robots.txt“.

- Ici, vous pouvez coller le contenu de votre fichier robots.txt et voir comment le robot de Google y réagit. L’outil vous montrera s’il rencontre des problèmes ou des erreurs.

5.2 Vérification des erreurs et des avertissements

Lorsque vous testez votre fichier, soyez attentif aux messages d’erreur ou d’avertissement. Ces messages peuvent indiquer des sections bloquées par erreur ou des directives mal formulées. Il est crucial de corriger ces erreurs pour garantir une exploration et une indexation optimales de votre site.

5.3 Comment corriger les problèmes potentiels rapidement

Si l’outil de test signale un problème :

- Vérifiez d’abord votre syntaxe : Assurez-vous que chaque directive “Allow” ou “Disallow” est correctement formatée.

- Revoyez les chemins : Assurez-vous que les chemins que vous avez inclus correspondent exactement aux sections de votre site que vous souhaitez cibler.

- Testez à nouveau : Après avoir apporté des modifications, testez à nouveau votre fichier pour vous assurer que les problèmes sont résolus.

6. Cas pratiques : exemples de configurations courantes de Robots.txt pour optimiser son site

La meilleure façon de comprendre comment fonctionne un fichier robots.txt est d’examiner des exemples concrets adaptés à différents types de sites.

6.1 Configuration pour un site e-commerce

Sur un site e-commerce, vous voudrez peut-être empêcher les robots d’indexer les pages de panier, de compte utilisateur ou de processus de commande. Voici comment :

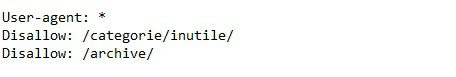

6.2 Configuration pour un blog ou un site d'actualités

Sur un blog, il pourrait être pertinent de bloquer l’accès à des catégories redondantes ou à des archives mensuelles qui pourraient être considérées comme du contenu en double.

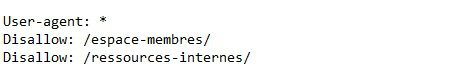

6.3 Configuration pour un site institutionnel ou corporatif

Sur un site institutionnel, vous pourriez vouloir protéger les zones réservées aux membres ou les ressources internes :

7. Les mythes courants concernant le fichier Robots.txt

Dans le monde du web, il y a beaucoup de “on-dit” et de malentendus. Le fichier robots.txt ne fait pas exception. Voyons quelques idées fausses courantes à ce sujet :

7.1 "Bloquer une page dans robots.txt la supprime des moteurs de recherche"

Il s’agit d’une idée fausse répandue. Même si vous bloquez une page dans votre robots.txt, elle peut toujours apparaître dans les résultats de recherche, surtout si d’autres sites la mentionnent ou y font référence. Le fichier robots.txt dit simplement aux robots de ne pas “explorer” la page, mais cela ne la supprime pas complètement de l’index des moteurs de recherche.

7.2 "La directive Crawl-delay doit être utilisée fréquemment pour préserver la bande passante"

Crawl-delay peut être utile, mais ce n’est pas toujours nécessaire. Sauf si vous avez un grand site avec des milliers de pages et que vous êtes préoccupé par le trafic du serveur, vous n’avez probablement pas besoin de l’utiliser. Et même dans ce cas, trop l’utiliser peut empêcher les moteurs de recherche de voir votre contenu à jour.

7.3 "Tout le monde respecte le fichier robots.txt"

Malheureusement, ce n’est pas vrai. Si la plupart des moteurs de recherche connus respectent vos directives, certains robots malveillants peuvent ignorer votre fichier robots.txt. C’est pourquoi il est essentiel d’avoir également d’autres mesures de sécurité en place.

8. Comment surveiller l'impact de votre Robots.txt sur le SEO ?

Vous avez optimisé votre fichier robots.txt, et maintenant ? Comment savoir s’il fonctionne comme prévu ? Voici quelques étapes pour le vérifier :

8.1 Analyser les logs serveurs pour voir comment les robots crawlers interagissent avec votre site

Les logs serveurs enregistrent toutes les activités sur votre site, y compris les visites des robots des moteurs de recherche. En les examinant, vous pouvez voir quelles pages ils visitent et s’ils respectent votre fichier robots.txt.

8.2 Surveiller l'indexation de vos pages à travers la Google Search Console

Google Search Console est un outil gratuit qui vous montre comment Google voit votre site. Il vous indiquera quelles pages sont indexées, si des problèmes sont détectés avec votre robots.txt et bien plus encore. Si certaines pages que vous avez bloquées dans robots.txt apparaissent toujours dans les résultats de recherche, vous pourrez le voir ici.

8.3 Utiliser des outils tiers pour des audits SEO complets et réguliers

Il existe de nombreux outils SEO sur le marché qui peuvent analyser votre site et vous donner des informations précieuses. Certains peuvent même simuler le parcours des robots des moteurs de recherche pour vous montrer exactement comment ils interagissent avec votre site. Cela peut vous aider à repérer des problèmes potentiels et à les résoudre rapidement.

9. Questions fréquemment posées (FAQ) sur le fichier Robots.txt

Même si vous n’avez rien à cacher, le fichier robots.txt est utile pour guider les robots des moteurs de recherche. Cela vous permet de contrôler quelles pages les robots vont explorer, ce qui peut aider votre site à être mieux représenté dans les résultats de recherche.

Pas nécessairement. De nombreux systèmes de gestion de contenu (comme WordPress) en créent un par défaut, mais ce n’est pas garanti. Vous pouvez vérifier en allant sur “votresite.com/robots.txt” . Si vous n’en avez pas, c’est une bonne idée d’en créer un.

Oui ! Chaque sous-domaine (comme blog.votresite.com) peut avoir son propre fichier robots.txt. Assurez-vous simplement de le placer à la racine de chaque sous-domaine.

“Disallow” dans robots.txt dit aux robots de ne pas explorer une page, tandis que “Noindex” est une balise qui dit aux robots de ne pas indexer une page. Cela signifie que même si une page est “Disallow”, elle pourrait toujours être indexée si d’autres sites la lient, à moins qu’elle n’ait également une balise “Noindex”.

Pas toujours. Les robots des moteurs de recherche doivent revisiter votre site et lire le fichier mis à jour. Cela peut prendre de quelques heures à quelques jours, en fonction de la fréquence à laquelle les robots visitent votre site.

10. Conclusion

Gérer correctement ce fichier peut aider votre site à se présenter sous son meilleur jour sur les moteurs de recherche, en veillant à ce que seuls les contenus pertinents soient mis en avant. Cependant, un mauvais usage peut cacher des parties essentielles de votre site aux yeux des internautes.

N’oubliez pas de revoir régulièrement votre fichier robots.txt, surtout si vous apportez des changements majeurs à votre site. De cette façon, vous vous assurez qu’il reflète toujours vos intentions et contribue à l’optimisation de votre présence en ligne.

Ps : Pour ne rien manquer de nos conseils pour accroitre la visibilité de votre site web, inscrivez-vous à la newsletter et recevez gratuitement votre guide.